你是否曾查看过服务器账单,为莫名的流量和资源消耗感到困惑?你的网站是否在某些时段变得异常缓慢,而真实访客并不多?问题的元凶,很可能就是那些在后台疯狂抓取的恶意网站爬虫。

对于个人站长或拥有小型网站的开发者来说,每一分流量、每一秒CPU时间都弥足珍贵。让恶意的、不守规矩的爬虫肆意消耗这些资源,无异于在浪费金钱和性能。今天,我就手把手教你如何识别并屏蔽它们,为你的网站“节流开源”。

第一步:识别不速之客——绘制你的爬虫地图

我的网站搭建于阿里云轻量应用服务器,并通过宝塔面板进行管理。程序选用Z-Blog,并安装了专门的蜘蛛日志记录插件,用于追踪爬虫访问动态及生成可视化统计图表。

第二步:发现资源浪费的源头——识别恶意爬虫

按下键盘上的“Win键+R键”(Win键即带Windows图标的按键),弹出“运行”对话框,输入“cmd”,点击“确定”或按回车,快速打开命令提示符。

输入nslookup52.167.144.195(蜘蛛IP地址),地址按回车。

如果结果中出现搜索引擎名称那么这就是真蜘蛛IP;

如果结果中出现:找不到IP地址:Non-existentdomain,那么这就是假蜘蛛IP

常见的搜索引擎爬虫(插件已经大部分识别)

Googlebot是谷歌的网络爬虫

Baiduspider是百度的网页爬虫

bingbot是微软bing搜索的爬虫

360Spider是360搜索的爬虫

Sogouwebspider是搜狗搜索的网页爬虫

YisouSpider是神马搜索的爬虫

YandexBot是俄罗斯最大搜索引擎和互联网巨头Yandex的网页爬虫,这个爬虫没有被插件识别,它的特点是短时间内有大量不同IP地址。

常见的“资源杀手”类型:

常见的“资源杀手”类型:

SEO数据采集器:如AhrefsBot,SemrushBot。它们为商业数据库抓取内容,对你个人毫无益处。

安全漏洞扫描器:它们会系统地请求/wp-admin、zb_system/cmd.php?act=verify、phpmyadmin、env等敏感路径,大量消耗资源。

内容剽窃爬虫:专门抓取全文,用于内容农场,通常不遵守任何规则。

第三步:行动指南——手把手配置屏蔽规则

我们将从温和劝退升级到强制拦截。

方法A:温和劝退(使用robots.txt)

在网站根目录的robots.txt文件中,明确告知守规矩的爬虫不要抓取。部分合规的商业爬虫会遵守此规则并停止抓取,对恶意爬虫和扫描器无效。

User-agent: *

Allow: /

Disallow: /zb_system/

Disallow: /search.php

Disallow: /zb_users/data/

Disallow: /zb_users/language/

Disallow: /zb_users/logs/

Disallow: /*.php?*

Disallow: /*.txt

Disallow: /*.log

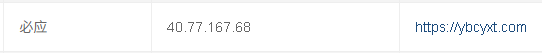

方法B:强制拦截(屏蔽恶意IP地址)

1. 登录宝塔面板,进入【安全】模块,点击【系统防火墙】。

2. 选择【IP规则】选项卡,点击【添加IP规则】。

3. 在IP地址输入框中,填入需要屏蔽的IP地址,多个IP之间使用英文逗号“,”隔开。

4. 【策略】选择“禁止”,【方向】选择“入站(默认)”。

5. 点击【确认】保存,即可完成IP屏蔽规则的添加。

第四步:定期更新

网络环境在变化,新的恶意爬虫会不断出现。建议每个月回顾一次访问日志,更新你的屏蔽列表。

对于资源有限的个人网站而言,主动管理爬虫访问不是一个可选的高级技巧,而是一项至关重要的运维工作。现在就花上半小时,为你的网站“减负”吧!